Publicado originalmente em *Desinformante por Matheus Soares. Para acessar, clique aqui.

O Instituto DaHora lançou uma campanha para mostrar os impactos das ferramentas de IA em populações racializadas e denunciar a falta de pessoas não-brancas no desenvolvimento destas ferramentas, onde estaria um dos problemas do racismo algorítmico.

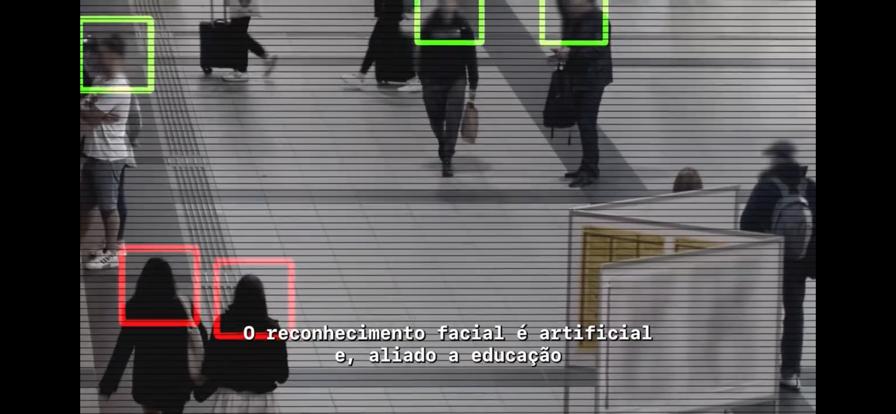

A campanha “Reconhecimento Artificial” busca evidenciar como o racismo está incrustado no desenvolvimento de tecnologias de reconhecimento facial, que seguem desconsiderando a diversidade da população mundial. Dessa forma, o instituto levanta a preocupação com esses sistemas, que vigiam a população para diversos fins, ameaçam direitos fundamentais e de segurança da população negra brasileira.

Policiamento discriminatório e violação de privacidade são alguns dos exemplos de riscos que essas tecnologias podem trazer ao terem um viés que desfavoreça determinadas pessoas. “No contexto do reconhecimento facial, o viés pode ocorrer quando os sistemas têm taxas de erro mais altas em relação a certos grupos étnicos, de gênero ou idade, levando à discriminação”, trouxe o Insituto.

Embora tentem minimizar, o racismo algoritmo existe, basicamente, porque as tecnologias são majoritariamente desenvolvidas por pessoas brancas (ou não-racializadas), diz a campanha do Instituto DaHora. Sendo assim, as ferramentas são criadas a partir da mesma vivência e perspectiva de privilégio. O principal deles é a segurança da existência e de acesso aos direitos humanos individuais e universais.

“Queremos reforçar e fomentar o debate sobre a importância do banimento do reconhecimento facial através do compartilhamento de informações e conhecimento sobre o tema”, diz o texto da campanha, que inclui um vídeo para circular nas redes sociais. Veja aqui:

De acordo com Tarcízio Silva, pesquisador do Mozilla Foundation, o racismo algorítmico é o modo pelo qual as tecnologias e os imaginários que as rondam, moldados num mundo marcado pela supremacia branca, realiza a ordenação algorítimica de forma racializada em detrimento de grupos minorizados. “Tal ordenação pode ser vista como uma camada adicional do racismo estrutural, que, além do mais, molda o futuro e os horizontes de relações de poder”, afirma o pesquisador em seu site, trazendo também uma linha do tempo de casos de discriminação algorítmica desde 2015.

Sistemas de reconhecimento já são realidade no Brasil

No último dia 16, a prefeitura de São Paulo começou a pôr em prática o projeto Smart Sampa, que visa instalar 20 mil câmeras na capital paulistana para monitoramento da população. Nesta primeira fase de implementação, cerca de 200 aparelhos já foram espalhados na região central da cidade. Ainda no início do mês, o Ministério Público de São Paulo (MPSP) se manifestou a favor da suspensão do projeto.

São Paulo, porém, não é um caso isolado. De acordo com um mapeamento realizado pelo Panóptico do Centro de Estudos de Segurança e Cidadania (CESeC), todos os estados do país possuem algum projeto de aplicação de tecnologias de reconhecimento facial. Ao todo, foram identificados 195 projetos pelo estudo, coordenado pelo pesquisador Pablo Nunes, e que resultaram na prisão de 509 pessoas entre 2019 e 2022. Do número de prisões, 90% delas foram de pessoas negras.

Enquanto isso, a União Europeia caminha para banir sistemas do tipo. As tecnologias de reconhecimento facial utilizadas em espaços públicos para coleta de dados e vigilância dos cidadãos são consideradas de altíssimo risco pelo projeto de lei da Inteligência Artificial (o AI Act, como é chamado em inglês), que está atualmente na fase das tratativas finais. Se for aprovado, o texto proibirá o uso dessas tecnologias por empresas e governos no bloco econômico.

Deputada Renata Souza denuncia racismo em trend da Pixar

A campanha chega no momento em que uma deputada estadual do Rio pelo Psol, Renata Souza, denunciou, na prática, uma ocorrência racista por parte de uma ferramenta de IA generativa da Microsoft. Ao gerar uma imagem baseada em sua autodescrição, a deputada Renata Souza foi apresentada a uma ilustração que trazia uma mulher negra segurando uma arma em uma favela. Ela disse que essa imagem comprova que as inteligências artificiais são racistas.

“Em momento nenhum eu falei sobre armas. Em momento nenhum eu falei sobre violência. Eu falei sobre mulher negra em uma favela. E aparece uma mulher negra com uma arma na mão. Ou seja: o racismo algorítmico está aí. Essa lógica de criminalização das pessoas negras desses territórios de favela e periferia, ela também está nos algoritmos”, afirmou Souza para a Agência Brasil.

Em resposta ao *desinformante, a assessoria da Microsoft afirmou que está investigando o relato da deputada e que tomará as medidas adequadas para ajustar nosso serviço. “Estamos totalmente comprometidos em melhorar a precisão dos resultados desta nova tecnologia e continuaremos fazendo investimentos adicionais para isso à medida que ela continua a evoluir”, disse a big tech em comunicado.