Publicado originalmente em Instituto Palavra Aberta por Mariana Mandelli. Para acessar, clique aqui.

Um vídeo de um garotinho aprendendo a andar à beira do abismo de uma usina hidrelétrica viralizou nos últimos dias. Agarrado a uma grade, ele dá passos incertos, quase tropeçando, enquanto se ouve o barulho intenso das quedas d’água lá embaixo. A sensação de que a qualquer momento ele vai cair é sufocante, mas é interrompida por um corte revelador: a cena é falsa. Na verdade, a criança está caminhando numa calçada e, entre ela e a guia, uma ótima edição inseriu imagem e som para manipular o telespectador.

O vídeo resume aquilo que se chama de VFX breakdown, conteúdos que mostram o antes e depois de efeitos especiais de modo tão fascinante que faz com que o telespectador veja e reveja a sequência repetidas vezes. Mas, por despertar emoções tão intensas em segundos – medo da criança morrer, revolta pelos responsáveis que o deixaram ali, choque pelo falseamento da realidade, entre outras –, também serve de alerta para o potencial destrutivo que a distorção audiovisual pode ter.

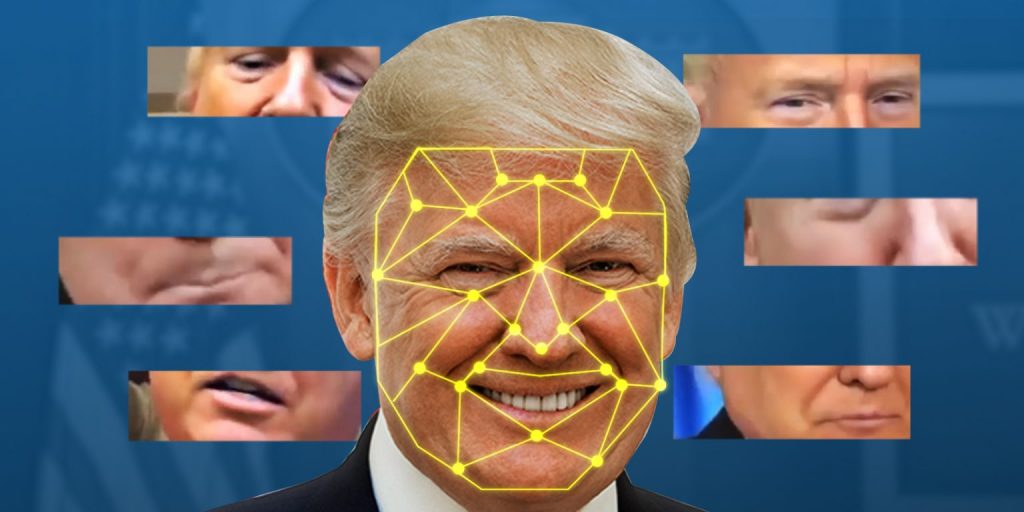

É justamente esse o maior risco da disseminação das deepfakes, imagens e vídeos que não alteram apenas cenários e vozes, mas rostos e corpos de pessoas por meio de inteligência artificial. Em linhas gerais, nesse tipo de manipulação digital é possível sobrepor e mudar semblantes, expressões, sincronização de lábios, olhares, membros – ou seja: tudo, e de forma muito realista, capaz de convencer até o mais atento dos usuários de redes sociais.

O uso desses vídeos vem crescendo exponencialmente nos últimos anos. Dados da empresa holandesa de cibersegurança DeepTrace mostram que, entre 2018 e 2019, o aumento foi de 100% no número de conteúdos desse tipo publicados em plataformas de streaming e de pornografia. Pior: 96% de todos os vídeos detectados pela companhia eram pornográficos e, claro, não autorizados pelas vítimas, o que significa que mulheres, famosas ou não, tiveram seus rostos colocados nos corpos de atrizes de filmes adultos .

Embora os alvos principais sejam as mulheres, ninguém está imune a deepfakes. Assim como outras formas de desinformação, esses vídeos podem demolir reputações, contribuindo para casos de cyberbullying, e interferir diretamente no debate político, causando danos na vida individual e coletiva de qualquer sociedade.

O estrago pode ser maior do que o compartilhamento de “fake news” e correntes de WhatsApp. Isso porque imagens hiper-realistas são mais difíceis de serem checadas, o que pode confundir nossos sentidos e embaralhar nosso senso crítico de modo muito mais rápido e eficaz do que uma mídia impressa ou em áudio. O poder da imagem em movimento é inegável e deepfakes se aproveitam exatamente disso.

Portanto, quanto mais sofisticada se torna essa técnica, mais venenosa ela pode ser, especialmente em ambientes polarizados como períodos eleitorais. Nos Estados Unidos, diversos políticos já tiveram seus rostos inseridos em mídias adulteradas, dos quais talvez o caso mais famoso tenha sido o do ex-presidente Barack Obama ofendendo o também ex-mandatário estadunidense Donald Trump. Por aqui, a ocorrência mais emblemática aconteceu em 2018, durante a campanha de João Doria ao governo de São Paulo, quando um suposto vídeo erótico foi divulgado antes da decisão do segundo turno.

Vale lembrar que o uso de deepfakes pode ser inocente, gerando pílulas de humor com base em cenas de séries, novelas e filmes, e também pedagógico, como ocorreu no Museu Dalí nos Estados Unidos, onde uma das exposições utilizou um painel digital que recriou o artista, morto em 1989, em vídeo. No entanto, isso infelizmente tem perdido espaço para os diversos tipos de corrosão social que essa tecnologia pode causar.

Enquanto as plataformas de mídias sociais como a Meta e o Twitter discutem o que fazer com esses conteúdos, aplicativos e ferramentas gratuitos para a produção de deepfakes se popularizam cada vez mais, desafiando o debate sobre direitos autorais e liberdades individuais e também a própria inteligência artificial, uma vez que o reconhecimento de mídias legítimas tem se tornado cada vez mais complicado (como se o feitiço virasse contra o feiticeiro).

Por mais midiaticamente educados e educadas que sejamos, é necessário assumir que, diante desse tipo de desinformação que desloca o nosso senso de realidade, é preciso vigilância constante. Alguns pesquisadores acreditam que, num futuro não tão distante, não conseguiremos diferenciar o que é verdadeiro do que é falso. Não acreditar facilmente no que nossos próprios olhos veem, como no caso do vídeo do menininho no alto de um penhasco hidrelétrico e tantos outros, pode ser uma atitude benéfica em termos individuais e, claro, democráticos. Uma dose de ceticismo saudável é – e será – cada vez mais importante em tempos hiperconectados.

*Mariana Mandelli é coordenadora de comunicação do Instituto Palavra Aberta