Publicado originalmente em *Desinformante por Liz Nóbrega. Para acessar, clique aqui.

Rótulos, remoções e desmonetização são alguns dos mecanismos utilizados pelas plataformas digitais para combater a desinformação sobre Covid-19 e saúde pública em geral. Em um estudo comparativo, a organização europeia EU DesinfoLab investigou como Facebook, Instagram, YouTube, TikTok e Twitter responderam ao tema nas suas políticas de uso.

O estudo liderado pela pesquisadora Maria Giovanna Sessa identificou que, em geral, as políticas contra desinformação sobre saúde se desenvolveram muito no contexto da pandemia de Covid-19, assim como a sobreposição dessas questões com políticas sobre discurso de ódio e discriminação. No entanto, há preocupações sobre a defasagem das ações.

“Atualmente, o senso de urgência da pandemia desapareceu, mas as estruturas desenvolvidas podem ser aplicadas a outras emergências e ao risco de danos iminentes, que continua sendo a razão fundamental para reconhecer e lidar com a desinformação em geral e a desinformação em saúde especificamente. No geral, a desinformação relacionada à vacina continua abundante, tornando-se crucial manter e aplicar uma política sólida que proteja indivíduos e comunidades”, elencou o relatório.

Na pesquisa comparativa entre as plataformas, o Twitter foi o que adotou menos políticas de combate à desinformação sobre saúde. “É extremamente preocupante que o Twitter não tenha mais uma política de desinformação sobre Covid-19 e saúde. Em geral, a plataforma parece usar termos como ‘desinformação’, ‘conteúdo enganoso’ ou ‘conteúdo falso’ de forma intercambiável. Além disso, a falta de verificação de fatos da plataforma por profissionais é alarmante”, concluiu a pesquisa.

O estudo também problematizou a ferramenta ‘notas da comunidade’ da empresa, em que os usuários podem incluir informações sobre o conteúdo do tweet realizando uma verificação de fatos “de baixo para cima”. De acordo com a pesquisadora, essa abordagem se mostrou falha por ter sido “sequestrada por espalhadores de desinformação”. Outro ponto destacado é a brecha deixada nos termos de uso para alegações em primeira pessoa.

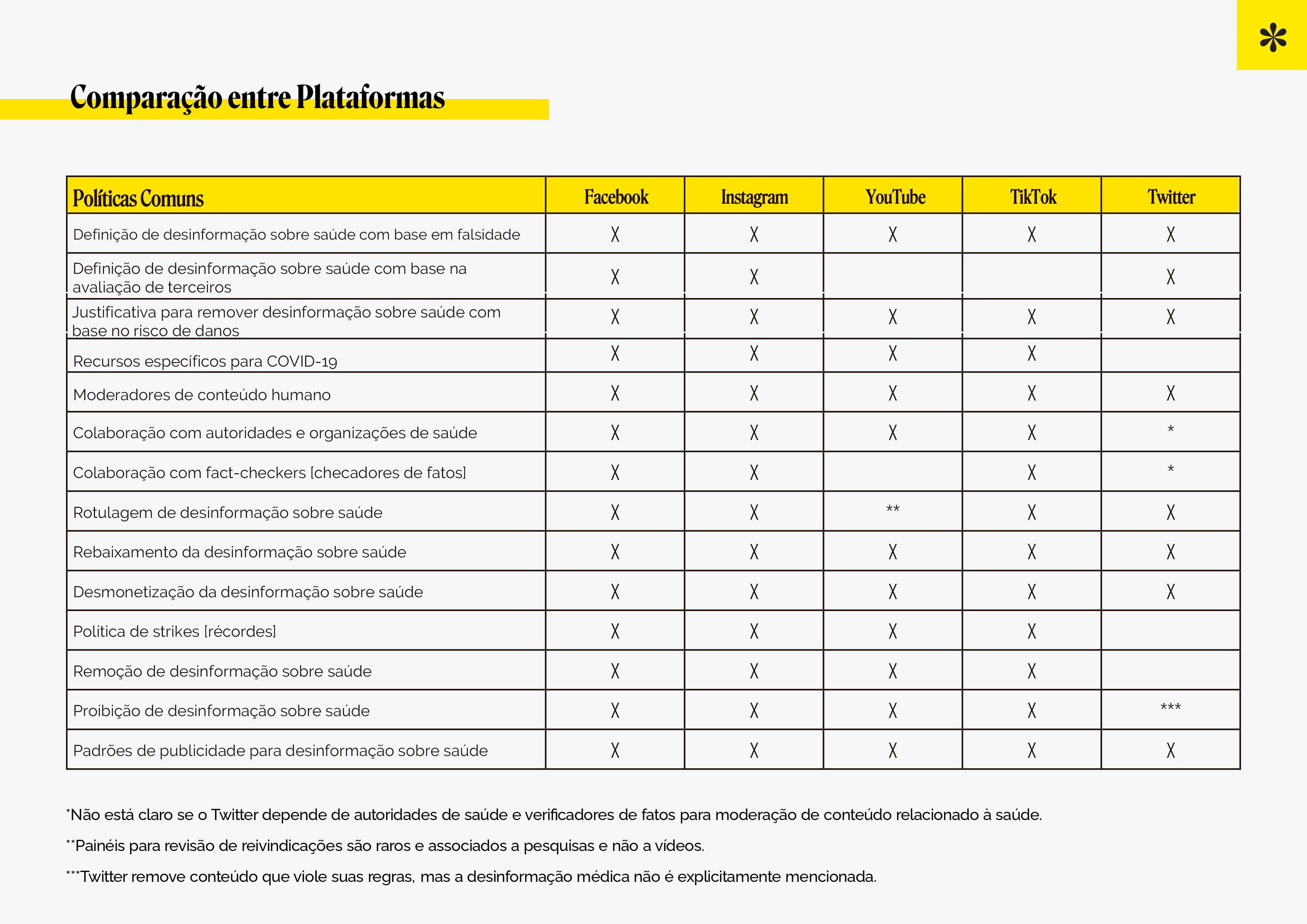

A investigação levou em conta os seguintes critérios: definição de desinformação sobre saúde com base em falsidade; definição de desinformação sobre saúde com base na avaliação de terceiros; justificativa para remover desinformação sobre saúde com base no risco de danos; recursos específicos para Covid-19; moderadores de conteúdo humanos; colaboração com autoridades e organizações de saúde; colaboração com fact-checkers; rotulagem de desinformação sobre saúde; rebaixamento da desinformação sobre saúde; desmonetização da desinformação sobre saúde; política de strikes; remoção de desinformação sobre saúde; proibição de desinformação sobre saúde; padrões de publicidade para desinformação sobre saúde.

Sobre o Facebook e Instagram, plataformas do grupo Meta, a pesquisa destacou como positivo o alinhamento das políticas de moderação nas duas redes, ou seja, o que é identificado como falso em uma é automaticamente rotulado na outra. “Esse tipo de harmonização de políticas entre plataformas é altamente desejável. Nesse sentido, uma tendência positiva é que essas grandes plataformas cooperem com os fact-checkers da International Fact-Checking Network”, pontuou o relatório.

No entanto, os pesquisadores ressaltaram a dificuldade da navegação pelas páginas das plataformas da Meta por haver uma falta de linearidade entre os sites que trazem as informações sobre as políticas de moderação de conteúdo.

Apesar de preencherem todos os pontos do mapeamento da pesquisa, as plataformas da Meta anunciaram recentemente mudanças sobre suas regras globais de desinformação sobre a Covid-19, retrocedendo no que foi estabelecido anteriormente. Pela nova política, a empresa só continuará removendo conteúdo desinformativo por “risco de danos físicos eminentes” nos países em que a declaração de emergência continua, o que não é o caso do Brasil.

Outro ponto de atenção que o estudo traz é a abordagem excessivamente branda que as plataformas adotam em relação à diferença entre fatos e opiniões, contribuindo para a desordem informacional.

“Como nota final, é justo referir que, pelo menos no papel, as plataformas parecem prestar especial atenção à proteção de menores, por exemplo, prevenindo comportamentos nocivos ligados à imagem corporal, distúrbios alimentares ou automutilação. Isso é especialmente verdadeiro para o TikTok, cujos usuários principais são muito jovens”, destacou o relatório como último achado da pesquisa.

Veja tabela comparativa das políticas das plataformas para combater a desinformação sobre saúde: